GPU / GPU - BASED SYSTEM

GPU・GPU搭載システム

GPUを装備した

高性能なコンピュータが必要ですか?

CUDA環境を中心にGPGPU(General-purpose computing on graphics processing units; GPUによる汎用計算)が長らく注目されています。

機械学習/AI/Deep Learningの活用に加え、量子シミュレーションや大規模言語モデル(Large Language Models:LLM)を含む各種生成AIにおいても、GPUは必須となっています。

VTでは、演算能力だけでなく、高解像度のグラフィックスが必要など、お客様のさまざまなミッションに適したGPU搭載サーバ/ワークステーション・ラックマウントサーバを提供しています。

エントリーモデルには1枚のGPUカードが搭載されていますが、本格的な取り組みには複数のコンピューティングボードやGPUボードを搭載したシステムや、NVLink/NVLink Bridgeを活用したシステムが必要です。これらのシステムでは、カードの消費電力や発生する熱に配慮した設計が重要です。また、複数のユーザが利用する場合は、日々進化する各種フレームワークの導入や更新にも配慮する必要があります。コンテナ環境の活用も有効です。VDI用途でのvGPUの活用なども、多くのノウハウが必要です。

お客様のニーズに合わせて、最適なシステム構築をサポートいたします。

GPU LINEUP

GPUラインアップ

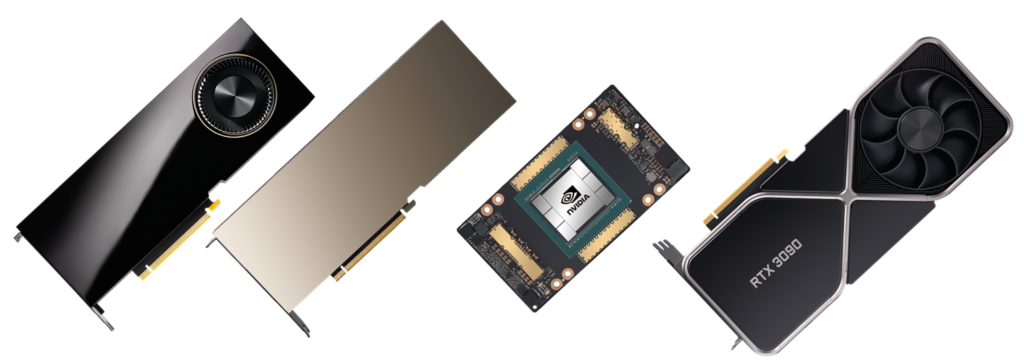

GPGPUでのデファクトスタンダードは、NVIDIA社製のGPUカードです。

現在、グラフィックスからAI処理まで幅広い演算能力を備えた汎用のGPUとして、NVIDIA Ada Lovelaceアーキテクチャが存在します。また、GPUメモリも急速に大容量化しています。

このAda Lovelaceアーキテクチャには、混合精度演算を行うTensorコア(第4世代)が搭載されており、ソフトウェアと組み合わせることで、AI学習における低精度の計算を高速に実行できるTransformer Engine機能が提供されています(高精度な計算が必要な場合には、この機能を無効にすることも可能です)。

さらに、NVIDIA Hopper アーキテクチャは、最高水準のAI学習向け製品として位置付けられています。このアーキテクチャは倍精度浮動小数点の演算もサポートしています。

生成AI/倍精度浮動小数点演算を必要とする数値計算やシミュレーション用途(グラフィック出力なし)

| ■ データ センター GPU | |||||||

|---|---|---|---|---|---|---|---|

| PCI Express | メモリ量 | アーキテクチャ | NVLink | MIG | 倍精度 | 単精度 | |

| H100 NVL | 5.0 x16 | 94GB | Hopper | ◯ | ◯ | ◯ | ◯ |

| A10 NC | 4.0 x16 | 24GB | Ampere | ─ | ─ | ─ | ◯ |

| L40S | 4.0 x16 | 48GB | Ada Lovelace | ─ | ─ | ─ | ◯ |

| L40 | 4.0 x16 | 48GB | Ada Lovelace | ─ | ─ | ─ | ◯ |

| A2 | 4.0 x8 | 16GB | Ampere | ─ | ─ | ─ | ◯ |

| A16 | 4.0 x16 | 4x 16GB | Ampere | ─ | ─ | ─ | ◯ |

| ■ ワークステーション GPU / データ サイエンスと HPC向け /Active FAN | |||||||

|---|---|---|---|---|---|---|---|

| PCI Express | メモリ量 | アーキテクチャ | NVLink | MIG | 倍精度 | 単精度 | |

| A800 40GB | 4.0 x16 | 40GB | Ampere | ◯ | ◯ | ◯ | ◯ |

AI推論/機械学習/単精度浮動小数点演算での数値計算やシミュレーション用途(グラフィック出力あり)

| ■ Ada 世代 NVIDIA Ada Lovelace | |||||||

|---|---|---|---|---|---|---|---|

| バス | メモリ量 | CUDAコア数 | Tensorコア数 | RTコア数 | 倍精度 | 単精度 | |

| RTX 6000 Ada | 4.0 x16 | 48GB | 18,176 | 568 | 142 | ─ | ◯ |

| RTX 5000 Ada | 4.0 x16 | 32GB | 12,800 | 400 | 100 | ─ | ◯ |

| RTX 4500 Ada | 4.0 x16 | 24GB | 7,680 | 240 | 60 | ─ | ◯ |

| RTX 4000 Ada ※1 | 4.0 x16 | 20GB | 6,144 | 192 | 48 | ─ | ◯ |

| RTX 4000 SFF Ada ※2 | 4.0 x16 | 20GB | 6,144 | 192 | 48 | ─ | ◯ |

| RTX 2000 Ada | 4.0 x8 | 16GB | 2,816 | 88 | 22 | ─ | ◯ |

※2 メモリー帯域幅 280GB/s,消費電力 70W

| ■ Aシリーズ NVIDIA Ampere | |||||||

|---|---|---|---|---|---|---|---|

| バス | メモリ量 | CUDAコア数 | Tensorコア数 | RTコア数 | 倍精度 | 単精度 | |

| RTX A5000 | 4.0 x16 | 24GB | 8,192 | 256 | 64 | ─ | ◯ |

| RTX A4500 | 4.0 x16 | 20GB | 7,168 | 224 | 56 | ─ | ◯ |

| RTX A4000 | 4.0 x16 | 16GB | 6,144 | 192 | 48 | ─ | ◯ |

| RTX A2000 | 4.0 x16 | 6GB/12GB | 3,328 | 104 | 26 | ─ | ◯ |

NVIDIA Ampere アーキテクチャ

.

GPUコンピューティングと

NVIDIA Ampereアークテクチャ

.

GPUスペック一覧を見る

GPGPUでは、GPUメモリへの高速なアクセスが処理パフォーマンスに大きく寄与します。 その為、PCIeバス(PCIe Ver3 x16)の約32GB/sを上回る300 GB/sのスピードでGPU間/GPU-CPU間を接続するNVLinkが開発されました。PCIeバスもVer4 の登場で倍の転送レートとなりましたが、NVLinlkも第3世代となり600GB/sへと進化しています。

またNVLinkは、アプリケーションのサポートが必要ですが、2枚のGPUカードをPCIeバスとは別に専用アダプタでNVLink接続するNVLinkSLIとしても応用されています。

GPU SYSTEM

GPU搭載システム

VT64シリーズ

処理能力・ストレージ量・高速ネットワークインタフェースなど、大きなカスタマイズ範囲を持つ、弊社オリジナルのオーダメイド製品です。NVLink対応製品や、3~最大20GPUに対応します。 Windows10やWindows Server、各種Linux等のOSをお選びいただけます。 コストパフォーマンスや特別な性能要求にも対応いたします。

メーカー製品

様々な特徴を持ち、特に高度な保守サービス、運用管理を容易にするシステム管理機能などでメリットのある大手メーカー製品を、適材適所でご提案いたします。 この他のメーカー製品についても、お問い合わせください。

-

HPE Apollo 6500 Gen10システム

4U1ノードのNVLinkに対応したハイエンドGPUサーバ。 「NVIDIA Tesla V100 GPU」を最大8基搭載。 更にPCIe3.0 x16スロットによるGPUカード搭載可能。

-

Dell EMC DSS 8440機械学習サーバ

4U1ノードのNVIDIA Tesla V100を最大10基搭載するサーバ。 最大10本のNVMe SSD、SAS/SATA SSD、InfiniBandのサポート、8本のPCIex16スロットなど、システム全体で「機械学習専用」を目指した高性能サーバ。

-

その他のサーバ

この他のメーカー製品についても、お問い合わせください。